Die Suche nach künstlicher Intelligenz (KI), die wie Menschen erschaffen, sich Dinge vorstellen und Innovationen hervorbringen kann, ist eine treibende Kraft in der Forschung zum maschinellen Lernen. Im Zuge dieses Strebens haben sich Diffusion models als neuartige Lösung in der generativen KI- Branche herauskristallisiert.

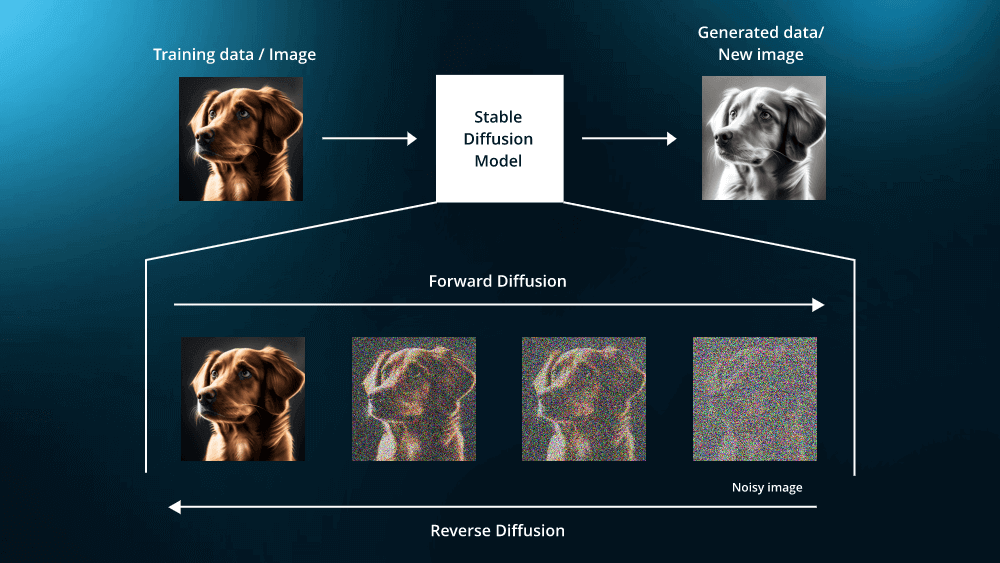

Diffusion models sind bei der Erzeugung hochwertiger Bilder, Videos, Sounds usw. von großer Bedeutung. Sie sind nach ihrer Ähnlichkeit mit dem natürlichen Diffusionsprozess in der Physik benannt, der beschreibt, wie sich Moleküle von Bereichen mit hoher Konzentration zu Bereichen mit niedriger Konzentration bewegen. Im Kontext des maschinellen Lernens erzeugen Diffusion models neue Daten, indem sie einen Diffusionsprozess umkehren, d. h. einen Informationsverlust aufgrund von Rauschen. Die Hauptidee besteht hier darin, den Daten zufälliges Rauschen hinzuzufügen und den Prozess dann rückgängig zu machen, um aus den verrauschten Daten die ursprüngliche Datenverteilung zu erhalten.

Beispiele für Diffusion models sind das bekannte DALL-E 2, Midjourney und das Open-Source-Programm Stable Diffusion, das auf Grundlage der Texteingabe des Benutzers realistische Bilder erstellt. In diesem Artikel erfahren wir mehr über generative Modelle, wie sie funktionieren und einige gängige Anwendungen.

Was sind Diffusion models

Diffusion models sind fortschrittliche Algorithmen des maschinellen Lernens, die auf einzigartige Weise qualitativ hochwertige Daten generieren, indem sie einem Datensatz schrittweise Rauschen hinzufügen und dann lernen, diesen Prozess umzukehren. Dieser innovative Ansatz ermöglicht es ihnen, bemerkenswert genaue und detaillierte Ergebnisse zu erstellen, von lebensechten Bildern bis hin zu zusammenhängenden Textsequenzen. Zentral für ihre Funktion ist das Konzept, die Datenqualität schrittweise zu verschlechtern, um sie dann in ihre ursprüngliche Form wiederherzustellen oder in etwas Neues umzuwandeln. Diese Technik verbessert die Genauigkeit der generierten Daten und bietet neue Möglichkeiten in Bereichen wie medizinischer Bildgebung, autonomen Fahrzeugen und personalisierten KI-Assistenten.

Wie Diffusion models funktionieren

Diffusion models arbeiten in einem Zweiphasenmechanismus: Sie trainieren zunächst ein neuronales Netzwerk, um Rauschen in den Datensatz einzuführen (ein wesentlicher Bestandteil des Vorwärtsdiffusionsprozesses) und kehren diesen Prozess dann methodisch um. Im Folgenden finden Sie eine detaillierte Aufschlüsselung des Lebenszyklus des Diffusionsmodells.

Datenvorverarbeitung

Bevor der Diffusionsprozess beginnt, müssen die Daten für das Modelltraining entsprechend formatiert werden. Dieser Prozess umfasst die Datenbereinigung zum Entfernen von Ausreißern, die Datennormalisierung zum konsistenten Skalieren von Merkmalen und die Datenerweiterung zum Erhöhen der Datensatzvielfalt, insbesondere bei Bilddaten. Die Standardisierung wird auch angewendet, um eine normale Datenverteilung zu erreichen, die für den Umgang mit verrauschten Bilddaten wichtig ist. Verschiedene Datentypen, wie Text oder Bilder, erfordern möglicherweise bestimmte Vorverarbeitungsschritte, wie z. B. das Beheben von Klassenungleichgewichtsproblemen. Eine gut ausgeführte Datenverarbeitung gewährleistet qualitativ hochwertige Trainingsdaten und trägt zur Fähigkeit des Modells bei, aussagekräftige Muster zu lernen und während der Inferenz qualitativ hochwertige Bilder (oder andere Datentypen) zu generieren.

Einführung von Rauschen: Vorwärtsdiffusionsprozess

Der Vorwärtsdiffusionsprozess beginnt mit der Stichprobenentnahme aus einer einfachen, normalerweise gaußschen Verteilung. Diese anfängliche einfache Stichprobe wird einer Reihe reversibler, inkrementeller Änderungen unterzogen, wobei jeder Schritt über eine Markow-Kette eine kontrollierte Menge an Komplexität einführt. Die Komplexität wird schrittweise erhöht, was häufig als Hinzufügen von strukturiertem Rauschen visualisiert wird. Diese Diffusion der anfänglichen Daten durch sukzessive Transformationen ermöglicht es dem Modell, die komplexen Muster und Details der Zielverteilung zu erfassen und zu reproduzieren. Das ultimative Ziel des Vorwärtsdiffusionsprozesses besteht darin, diese einfachen Anfänge zu Stichproben weiterzuentwickeln, die die gewünschte komplexe Datenverteilung genau nachahmen. Das ultimative Ziel des Vorwärtsdiffusionsprozesses besteht darin, diese einfachen Anfänge zu Stichproben weiterzuentwickeln, die die gewünschte komplexe Datenverteilung genau nachahmen. Dies zeigt wirklich, wie ein Beginn mit minimalen Informationen zu reichhaltigen, detaillierten Ergebnissen führen kann.

Beim Vorwärtsdiffusionsprozess wird das kleine Gaußsche Rauschen inkrementell über T Schritte zur Verteilung hinzugefügt, was zu einer Reihe zunehmend verrauschter Proben führt. Das bei jedem Schritt hinzugefügte Rauschen wird durch einen Varianzplan βt∈(0,1)t=1Tβt∈(0,1)t=1 T geregelt .

Hier wird q(xₜ∣xₜ₋₁) durch den Mittelwert µ definiert .

Rückdiffusionsprozess

Dieser umgekehrte Prozess unterscheidet Diffusion models von anderen generativen Modellen , wie etwa generativen kontradiktorischen Netzwerken (GANs) . Der umgekehrte Diffusionsprozess umfasst das Erkennen der spezifischen Rauschmuster, die bei jedem Schritt eingeführt werden, und das Trainieren des neuronalen Netzwerks, um die Daten entsprechend zu entrauschen. Dies ist kein einfacher Prozess, sondern erfordert eine komplexe Rekonstruktion durch eine Markow-Kette. Das Modell verwendet sein erworbenes Wissen, um das Rauschen bei jedem Schritt vorherzusagen und entfernt es dann sorgfältig.

Diffusionsmodelltechniken

Für die Funktionsweise des Diffusionsmodells sind mehrere Schlüsselmechanismen von zentraler Bedeutung, die gemeinsam seine Leistungsfähigkeit bestimmen. Das Verständnis dieser Elemente ist entscheidend, um zu verstehen, wie Diffusion models funktionieren. Dazu gehören die auf Punktzahlen basierende generative Modellierung, Rauschunterdrückung bei probabilistischen Diffusion models und stochastische Differentialgleichungen, die alle eine entscheidende Rolle bei der Fähigkeit des Modells spielen, komplexe Daten zu verarbeiten und zu generieren.

Stochastische Differentialgleichungen (SDEs)

SDEs sind mathematische Werkzeuge, die den Rauschzugabeprozess in Diffusion models beschreiben. Sie liefern eine detaillierte Blaupause, wie den Daten im Laufe der Zeit schrittweise Rauschen hinzugefügt wird. Dieses Framework ist wichtig, da es Diffusion models die Flexibilität verleiht, mit verschiedenen Datentypen und Anwendungen zu arbeiten, sodass sie für verschiedene generative Aufgaben angepasst werden können.

Score-basierte generative Modelle (SGMs)

Hier lernt das Modell, den Prozess der Rauschzugabe zu verstehen und umzukehren. Stellen Sie sich vor, Sie fügen einem Bild Rauschschichten hinzu, bis es nicht mehr zu erkennen ist. Die scorebasierte generative Modellierung lehrt das Modell, das Gegenteil zu tun – mit verrauschten Daten zu beginnen und das Rauschen schrittweise zu entfernen, um klare, detaillierte Bilder zu erhalten. Dieser Prozess ist entscheidend, um aus zufälligem Rauschen realistische Ergebnisse zu erzeugen.

Rauschunterdrückung bei probabilistischen Diffusion models (DDPMs)

Rauschreduzierende Diffusionsprobabilistische Modelle (DDPMs) sind ein spezieller Typ von Diffusion models, der sich auf die wahrscheinlichkeitsbasierte Entfernung von Rauschen aus Daten konzentriert. Während des Trainings lernen sie, wie den Daten im Laufe der Zeit Rauschen hinzugefügt wird und wie dieser Prozess umgekehrt werden kann, um die ursprünglichen Daten wiederherzustellen. Dabei werden Wahrscheinlichkeiten verwendet, um fundierte Vermutungen darüber anzustellen, wie die Daten aussahen, bevor Rauschen hinzugefügt wurde. Dieser Ansatz ist für die Fähigkeit des Modells zur genauen Rekonstruktion von Daten unerlässlich und stellt sicher, dass die Ergebnisse nicht nur rauschfrei sind, sondern auch den ursprünglichen Daten sehr ähnlich sind.

Zusammen ermöglichen diese Komponenten Diffusion models, einfaches Rauschen in detaillierte und realistische Ausgaben umzuwandeln, was sie zu leistungsstarken Werkzeugen in der generativen KI macht. Das Verständnis dieser Elemente hilft dabei, die komplexe Funktionsweise und Fähigkeiten von zu verstehen.

GAN vs. Diffusionsmodell

Lassen Sie uns über die Vorteile von Diffusion models, ihre Notwendigkeit und ihre Vorteile gegenüber GANs sprechen .

Bildqualität

Ein Hauptvorteil von Diffusion models gegenüber GANs und VAEs ist die einfache Trainierbarkeit mit einfachen und effizienten Verlustfunktionen und ihre Fähigkeit, hochrealistische Bilder zu erzeugen. Sie zeichnen sich dadurch aus, dass sie die Verteilung realer Bilder möglichst genau abbilden und sind in dieser Hinsicht GANs überlegen. Diese Fähigkeit ist auf die unterschiedlichen Mechanismen in Diffusion models zurückzuführen, die eine präzisere Nachbildung realer Bilder ermöglichen.

Trainingsstabilität

In Bezug auf die Trainingsstabilität haben generative Diffusion models einen Vorteil gegenüber GANs. GANs haben oft mit „Moduskollaps“ zu kämpfen, einer Einschränkung, bei der sie eine begrenzte Ausgabevielfalt produzieren. Diffusion models vermeiden dieses Problem effektiv durch ihren schrittweisen Datenglättungsprozess, was zu einer vielfältigeren Palette generierter Bilder führt.

Eingabetypen

Es ist auch wichtig zu erwähnen, dass Diffusion models verschiedene Eingabetypen verarbeiten. Sie führen verschiedene generative Aufgaben aus, wie Text-zu-Bild-Synthese, Layout-zu-Bild-Generierung, Inpainting und Superauflösungsaufgaben.

Anwendungen von Diffusion models

Es gibt sehr unterschiedliche Anwendungsgebiete für Diffusion models, eine der spannendsten ist die digitale Kunst. Künstler können diese Modelle nutzen, um abstrakte Konzepte oder Textbeschreibungen in detaillierte, visuell beeindruckende Bilder umzuwandeln. Diese Fähigkeit ermöglicht eine neue Form des künstlerischen Ausdrucks, bei der die Grenzen zwischen Technologie und Kunst verschwimmen und es den Künstlern ermöglicht wird, neue Stile und Ideen zu erkunden, die zuvor nur schwer oder gar nicht umsetzbar waren.

Grafikdesign

Im Grafikdesign und in der Illustration sind Diffusion models ein Werkzeug zur schnellen Generierung visueller Inhalte. Designer können Skizzen, Layouts oder grobe Ideen eingeben und die Modelle können diese zu vollständigen, ausgefeilten Bildern ausarbeiten. Dies kann den Designprozess erheblich beschleunigen und bietet eine Reihe von Möglichkeiten vom ersten Konzept bis zum Endprodukt.

Hier ist ein Beispiel für ein Diffusionsmodell – ein abgestimmtes Modell für Grafikdesign:

Film und Animation

Eine weitere kreative Anwendung findet sich im Bereich Film und Animation. Diffusion models können realistische Hintergründe, Charaktere oder sogar dynamische Elemente innerhalb von Szenen erzeugen und so den Zeit- und Arbeitsaufwand herkömmlicher Produktionsmethoden reduzieren. Dies rationalisiert den Arbeitsablauf und ermöglicht mehr Experimentierfreude und Kreativität beim visuellen Geschichtenerzählen.

Ein Künstler verwendete eine Reihe von Stable-Diffusion-Algorithmen, um die erste vollständige KI-Animation zu erstellen . Der weniger als zwei Minuten lange Film ist eine Zusammenarbeit zwischen dem Künstler, KI und mehreren Softwaretools wie Daz3D, Unreal Engine, Adobe Photoshop, Adobe After Effects und Adobe Premiere. Es ist der neueste in einer Reihe von KI-generierten Filmen, zu denen auch Kurzfilme im Anime-Stil gehören.

Musik und Sounddesign

In der Musik- und Soundgestaltung können generative Diffusion models angepasst werden, um einzigartige Klanglandschaften zu erzeugen oder Musik darzustellen, und bieten Künstlern neue Möglichkeiten, Hörerlebnisse zu visualisieren und zu schaffen.

Ein Artikel mit dem Titel „ Kontrollierbare Musikproduktion mit Diffusion models und Leitgradienten “ diskutiert ein Beispiel für ein Diffusionsmodell, das in der Musikindustrie verwendet wird. Die Autoren zeigen, wie die bedingte Generierung aus Diffusion models verwendet werden kann, um eine Vielzahl realistischer Aufgaben bei der Produktion von Musik in 44,1-kHz-Stereo-Audio mit Sampling-Zeit-Leitung zu bewältigen. Die von uns betrachteten Szenarien umfassen die Fortsetzung, Neubearbeitung und Regeneration von Musik-Audio, die Erstellung sanfter Übergänge zwischen zwei Musiktiteln und die Übertragung gewünschter stilistischer Merkmale auf vorhandene Audioclips.

Medien- und Gaming-Industrie

Auch die interaktive Medien- und Spielebranche kann von Diffusion models profitieren. Mit ihnen lassen sich detaillierte Umgebungen, Charaktere und andere Elemente erstellen, die Spielen und interaktiven Erlebnissen Realismus und Immersion verleihen, was bisher nur schwer zu erreichen war.

Im Wesentlichen sind Diffusion models ein leistungsstarkes Werkzeug für jeden im kreativen Bereich, da sie eine Kombination aus Präzision, Effizienz und künstlerischer Freiheit bieten. Diese Modelle ermöglichen es Kreativen, die Grenzen traditioneller Medien zu erweitern, neue Ausdrucksformen zu erkunden und fantasievolle Konzepte mit beispielloser Leichtigkeit und Detailtreue zum Leben zu erwecken.

Hier finden Sie eine vollständige Anleitung zu Anwendungen und Techniken zur Verwendung von KI-Bildgenerierungstools in Videospielen.

Bildgenerierung in SuperAnnotate

Auf dem GenAI-Spielplatz von SuperAnnotate können Benutzer vorgefertigte Vorlagen für ihre LLM- und GenAI-Anwendungsfälle ausprobieren oder eigene erstellen. Zu den am häufigsten verwendeten Vorlagen gehören GPT-Feinabstimmung , überwachte Feinabstimmung , Chat-Bewertung , RLHF für die Bildgenerierung und andere. Für Diffusion models sprechen wir über die Vorlage zur Bildgenerierung.

Die RLHF-Vorlage zur Bildgenerierung sieht folgendermaßen aus:

Sie können entweder diese Vorlage verwenden oder basierend auf dem vorliegenden Projekt eine eigene erstellen. Die Anpassbarkeit des Tools ermöglicht es Ihnen, Ideen in die Tat umzusetzen und die Vorlage entsprechend anzupassen. Wenn Sie Ihren Anwendungsfall erstellen, führen wir Sie von Grund auf durch die einzelnen Schritte.

Der erste Schritt besteht darin, die Benutzeroberfläche zu erstellen. Das Coole an diesem Tool ist, dass Sie sich einfach die Builder-Sammlung ansehen müssen, mit der Sie Ihr Formular anpassen können.

Für diesen RLHF-Fall bauen wir es folgendermaßen.

Eingabe

=> Button => Auswählen => Bilder in gewünschter Anzahl => Annotation in Rankingform => Annotation in

Textform

Der nächste Schritt ist die Umbenennung der Komponenten.

Lassen Sie uns die Vorlage in die Tat umsetzen.

Stellen Sie sich vor, Sie entwerfen Anzeigen für Lego und haben die coole Idee, die Chinesische Mauer aus Legosteinen auf einem Poster darzustellen. Sie möchten sich aber nicht auf nur wenige Optionen beschränken. Für diese Art von Projekt möchten Sie die Ergebnisse Ihres Modells bewerten und eine Textanmerkung dazu haben, warum das am höchsten bewertete Ergebnis das beste ist. Im Lego-Szenario war die dritte Option unser Favorit, weil sie die Schönheit des Gebäudes in all seiner Pracht perfekt einfängt.

Das RLHF-Tool zur Bildgenerierung von SuperAnnotate bietet eine Reihe solider Funktionen, darunter:

- Hohe Anpassungsfähigkeit

- Starke Datenverwaltung und -sicherheit

- Effiziente Datenkuratierung

- Fachspezifische Schulungen

Das heißt, wenn Sie Bilder für ein bestimmtes Projekt erstellen möchten, müssen Sie nicht ständig vorhandene Diffusion models aufrufen. Die ständige Aufforderung kann lästig werden, wenn die Ergebnisse nicht ganz Ihren Anforderungen entsprechen. Stattdessen können Sie mit SuperAnnotate eine Vorlage auswählen oder erstellen, Bilder generieren, die Ergebnisse überprüfen und bewerten und dies nach Bedarf wiederholen, um Trainingsdaten zu sammeln.

Egal, ob Sie ein paar einzigartige Bilder erstellen oder eine große Marketingkampagne starten, dieses Tool ist für Sie da. Seine Anmerkungs- und Ranglistenfunktionen helfen Ihnen dabei, die bestmöglichen Ergebnisse zu erzielen.

Beliebte Diffusionswerkzeuge

Zu den beliebtesten Diffusion models, die aufgrund ihrer beeindruckenden Fähigkeiten bei der Bilderzeugung große Aufmerksamkeit erregt haben, gehören:

DALL-E 2

DALL-E 2 wurde von OpenAI entwickelt und ist für seine hochdetaillierten und kreativen Bilder aus Textbeschreibungen bekannt. Es verwendet fortschrittliche Diffusionstechniken, um Bilder zu erzeugen, die sowohl fantasievoll als auch realistisch sind, was es zu einem beliebten Werkzeug in kreativen und künstlerischen Anwendungen macht.

DALL-E 3

DALL-E 3 ist die neueste Version der OpenAI-Bildgenerierungsmodelle und stellt gegenüber DALL-E 2 eine enorme Weiterentwicklung dar. Die bemerkenswerteste Änderung besteht darin, dass diese neueste Version nicht nur eine App ist, sondern in ChatGPT integriert ist. Sie zeichnet sich auch durch ihre Bildgenerierungsqualität aus.

Hier ist ein Vergleich von DALL-E 2 und DALL-E 3 mit derselben Eingabeaufforderung.

Sora

Sora ist das neueste Modell von OpenAI und es ist ein echter Game-Changer. Die KI-Community hat auf diesen Release gewartet, da es sich um das erste Text-zu-Video-Modell von OpenAI handelt. Sora kann 1080p-Videos in jeder Auflösung mit einer Länge von bis zu einer Minute erstellen und die erstellten Videos sind erschreckend realistisch. Sora ist jetzt auf eine ausgewählte Gruppe von Benutzern und Red-Teamern beschränkt, was begrüßenswert ist, da es zeigt, dass OpenAI hinsichtlich der ethischen Vorschriften des Modells vorsichtig ist. Man möchte nicht in jeder Ecke des Internets 100 Prozent realistische Deepfakes von Politikern haben.

Hier sind einige Sora-Beispiele, die die Leute sprachlos machten.

Prompt: Die Kamera ist direkt auf farbenfrohe Gebäude in Burano, Italien, gerichtet. Ein süßer Dalmatiner schaut durch ein Fenster im Erdgeschoss eines Gebäudes. Viele Menschen gehen zu Fuß oder radeln entlang der Kanalstraßen vor den Gebäuden.

Aufforderung: Eine stilvolle Frau geht eine Straße in Tokio entlang, die mit warm leuchtenden Neonlichtern und animierten Stadtschildern gefüllt ist. Sie trägt eine schwarze Lederjacke, ein langes rotes Kleid und schwarze Stiefel und hat eine schwarze Handtasche dabei. Sie trägt eine Sonnenbrille und roten Lippenstift. Sie geht selbstbewusst und lässig. Die Straße ist feucht und reflektierend, wodurch ein Spiegeleffekt der bunten Lichter entsteht. Viele Fußgänger gehen umher.

Aufforderung: Archäologen entdecken in der Wüste einen gewöhnlichen Plastikstuhl, graben ihn mit großer Sorgfalt aus und entstauben ihn.

Stabile Diffusion

Stable Diffusion wurde von Forschern bei Stability AI entwickelt , die zuvor an der Erfindung der von Stable Diffusion verwendeten latenten Diffusionsmodellarchitektur beteiligt waren. Dieses Modell zeichnet sich durch seine Effizienz und Effektivität bei der Umwandlung von Textaufforderungen in realistische Bilder aus. Es wurde für seine hochwertigen Bilderzeugungsfunktionen anerkannt.

Stable Diffusion 3 ist die neueste Version von Stability AI und sie ist beeindruckend. Es ist ihr leistungsfähigstes Text-zu-Bild-Modell mit stark verbesserter Leistung bei Eingabeaufforderungen für mehrere Themen, Bildqualität und Rechtschreibfähigkeiten. Sehen Sie sich den schrägen Text „Stable Diffusion“ an der Seite des Busses an. Dies war früher ein Traum für Bildgenerierungstools.

Die Stable Diffusion 3-Kollektion umfasst Modelle mit Parametern von 800 M bis 8 B und spiegelt den Willen von Stability AI wider, den Zugang für alle zu erweitern. Diese Vielfalt stellt sicher, dass Benutzer die perfekte Lösung für ihre Skalierbarkeits- und Qualitätsanforderungen finden und so ihre Kreativität anregen können. Sie haben gerade die Warteliste für eine frühe Vorschau geöffnet.

Aufforderung: Auf dem Küchentisch liegt ein besticktes Tuch mit dem Text „Gute Nacht“ und einem aufgestickten Tigerbaby. Neben dem Tuch brennt eine Kerze. Die Beleuchtung ist gedämpft und dramatisch .

Die stabile Diffusion bietet außerdem eine spannende Anwendung, mit der ein Bild in verschiedene Richtungen erweitert werden kann. Dies wird als stabiles Diffusions-Outpainting bezeichnet und wird verwendet, um ein Bild über seine ursprünglichen Grenzen hinaus zu erweitern.

Mitten auf der Reise

Midjourney ist ein weiteres Diffusionsmodell, das über eine API verfügbar ist und kürzlich veröffentlicht wurde. Es wird, ähnlich wie die anderen Modelle, zur Bildgenerierung aus Textaufforderungen verwendet. Spannend ist, dass der jüngste Hype um Midjourneys neueste Version, Midjourney v6 , dessen Fortschritte und verbesserte Fähigkeiten bei der Generierung noch raffinierterer und kreativerer Bilder unterstreicht.

Midjourney ist exklusiv über Discord erhältlich – wahrscheinlich der unorthodoxeste Ansatz aller aufgeführten Modelle GPT Agents.

Hier ist ein Porträtbildvergleich zwischen Midjourney V5.2 und Midjourney V6.

NAI-Verbreitung

NovelAI Diffusion bietet dem Benutzer ein einzigartiges Erlebnis bei der Bildgenerierung. Es ist ein kreatives Tool, mit dem Sie Ihre Visionen ohne Einschränkungen visualisieren und die Geschichten Ihrer Fantasie malen können. Das klingt ziemlich faszinierend und ist es auch. Hier sind die wichtigsten Funktionen des NovelAI-Bildgenerators:

- Text-zu-Bild-Generierung: Geben Sie eine Phrase namens „Eingabeaufforderung“ ein und die KI generiert ein Bild für Sie.

- Bild-zu-Bild-Generierung: Laden Sie ein Bild hoch (oder verwenden Sie ein zuvor generiertes), um ein neues Bild zu generieren.

- Inpainting: Übermalen Sie einen Teil des Bildes und generieren Sie ihn neu.

Bild

Imagen wurde von Google entwickelt und ist ein Text-zu-Bild-Diffusionsmodell, das für seinen Fotorealismus und sein tiefes Sprachverständnis bekannt ist. Es verwendet große Transformer-Sprachmodelle zur Textkodierung und erreicht eine hochpräzise Bilderzeugung. Imagen ist für seinen hohen FID-Score bekannt, der auf seine Effektivität bei der Erzeugung von Bildern hinweist, die der von Menschen bewerteten Qualität und Text-Bild-Ausrichtung sehr nahe kommen.

Vergleich der neuesten Diffusion models

Wir haben bereits einige Vergleiche von Modellen mit ihren älteren Versionen für Midjourney und DALL-E gesehen. Lassen Sie uns nun verschiedene Akteure von Diffusion models vergleichen und sehen, wer wo besser abschneidet.

Stabile Diffusion 3 vs. DALL-E 3

Einige Benutzer sagen, dass Stable Diffusion 3 DALL-E 3 bei der Bildgenerierung schlägt, insbesondere bei der Textgenerierung und dem Befolgen von Anweisungen.

Aufforderung: Kinofoto eines roten Apfels auf einem Tisch in einem Klassenzimmer, an der Tafel stehen mit Kreide die Worte „go big or go home“ (alles oder nichts).

Aufforderung: Ein Gemälde eines Astronauten, der auf einem Schwein reitet, das ein Tutu trägt und einen rosa Regenschirm hält. Auf dem Boden neben dem Schwein sitzt ein Rotkehlchen mit einem Zylinder und in der Ecke steht das Wort „stabile Diffusion“.

Midjourney v6 gegen DALL-E 3

Der spannendste Vergleich wäre der zwischen den neuesten Modellen der Bilderzeugungsgiganten – DALL-E 3 und Midjourney v6. Welches ist also das bessere Modell?

- Midjourney ist besser in puncto Fotorealismus und Details, DALL-E 3 beherrscht Qualität und Konsistenz, aber es mangelt ihm an Fotorealismus.

- Midjourney läuft auf Discord und ist benutzerfreundlicher, während DALL-E OpenAI-Zugriff und Tools von Drittanbietern erfordert.

- Für Midjourney V6 fällt eine Abonnementgebühr an; für DALL-E fallen je nach Plan unterschiedliche Kosten an.

Aufforderung: eine realistische Nahaufnahme eines älteren Mannes in einer städtischen Umgebung, der an einer Türöffnung lehnt, die Hand vor dem Gesicht hält und eine Zigarre raucht. Keine Emotionen. Fernblick in den Augen. Launisch und neblig.

Aufforderung: Ein grafisch gestaltetes Logo für ein Unternehmen namens Buzz Coffee, das sehr starken Kaffee verkauft.

Aufforderung: ein kreatives, grafisch gestaltetes, quadratisches Poster für eine Elektromusikband aus den späten 1990er Jahren. Flyer-Art-Stil.

Midjourney v6 vs. SDXL

Einige Vergleiche von Midjourney v6 vs. SDXL von Stable Diffusion:

Einschränkungen des Diffusionsmodells

Die Bereitstellung von Diffusion models wie denen in DALL-E kann eine Herausforderung darstellen. Sie sind rechenintensiv und erfordern erhebliche Ressourcen, was für Echtzeit- oder Großanwendungen ein Hindernis darstellen kann. Darüber hinaus kann ihre Fähigkeit zur Verallgemeinerung auf unbekannte Daten begrenzt sein, und ihre Anpassung an bestimmte Domänen kann umfangreiche Feinabstimmungen oder Neuschulungen erfordern.

Die Integration dieser Modelle in menschliche Arbeitsabläufe ist ebenfalls eine Herausforderung, da sichergestellt werden muss, dass die von der KI generierten Ergebnisse den menschlichen Absichten entsprechen. Ethische und voreingenommene Bedenken sind weit verbreitet, da Diffusion models Verzerrungen aus ihren Trainingsdaten erben können, was kontinuierliche Anstrengungen zur Gewährleistung von Fairness und ethischer Übereinstimmung erforderlich macht.

Aufgrund ihrer Komplexität sind Diffusion models außerdem schwer zu interpretieren, was bei Anwendungen, bei denen das Verständnis der Gründe für die Ergebnisse von entscheidender Bedeutung ist, zu Herausforderungen führt. Die Verwaltung der Benutzererwartungen und die Einbeziehung von Feedback zur Verbesserung der Modellleistung ist ein fortlaufender Prozess bei der Entwicklung und Anwendung dieser Modelle.

Ein weiterer großer Nachteil ist die langsame Samplingzeit: Um qualitativ hochwertige Samples zu generieren, sind Hunderte oder Tausende von Modellauswertungen erforderlich. Es gibt zwei Möglichkeiten, dieses Problem zu lösen: Die erste besteht in neuen Parametrisierungen von Diffusion models, die bei Verwendung weniger Sampling-Schritte eine höhere Stabilität bieten. Die zweite Methode ist die Destillation von geführten Diffusion models. Progressive Destillation für schnelles Sampling von Diffusion models zur Destillation eines trainierten deterministischen Diffusionssamplers führt zu einem neuen Diffusionsmodell, das nur halb so viele Sampling-Schritte benötigt.

Einpacken

Diffusion models haben unsere Vorstellung von der Fähigkeit der KI, Bilder, Videos und Töne zu erzeugen, grundlegend verändert. Diese Modelle funktionieren, indem sie zunächst Rauschen in die Daten einbringen und es dann geschickt entfernen, wodurch sie komplexe und qualitativ hochwertige Muster erstellen können. In diesem Artikel haben wir uns damit befasst, wie diese Modelle funktionieren, welche innovativen Techniken sie verwenden und wo sie eingesetzt werden. Diffusion models fördern nicht nur die Kreativität in Kunst und Design, sondern machen auch Fortschritte in der medizinischen Bildgebung und der Entwicklung selbstfahrender Autos. Ihre Vielseitigkeit bietet einen faszinierenden Einblick in die fortlaufende Entwicklung und die wachsenden Möglichkeiten der KI.